SEOを行う上で、挙動がしっかりと分かっていない機能を使う事は予想以上に恐ろしい事態を招く可能性があります。

今回はそんな恐ろしさの一端を見て頂きたく(笑)、robots.txtに関する実験を記事にしました。

去年の末頃に実験してみたサイトの紹介と最終的にどう対処したか?という事を記載したいと思います。

意図的にインデックス削除させてみた

2011年4月9日追記

※今回の実験を行ったのは、2011年10月初旬です。

現在の状況と挙動が違う可能性があるのでご注意下さい。

Googleのガイドライン違反によるペナルティでインデックス削除が行われる事もありえる昨今ですが、今回は意図的にrobots.txtを使用してインデックス削除をしてみました。

以下、インデックス削除方法です。(危険なので真似しないで下さい)

robots.txtに

User-agent: *

Disallow: /

と記載して待ちます。

私の実験サイトの場合、2日後にインデックスが削除されました。

ちなみに今回の実験では試していませんが、別の方法として、

<meta name=”robots” content=”noindex,nofollow”>

を全ページに記載するという方法もあります。

繰り返しますが真似をしてはいけません。

robots.txtの記述を元に戻してインデックスされるかを待ってみた

先の実験を行ったサイトのrobotx.txtの記述を以下の通り修正してみました。

User-agent: *

Disallow:

[/(スラッシュ)]を消しただけなんですけどね。

まずは、この状態で待ってみましたが1ヶ月経過しても再インデックスされません。

適当に内容を更新してみましたが再インデックスされません。

試しに外部からリンクをちょっとだけ付与してみましたが、やはり再インデックスされません。

ちなみにこれら全部試して約3ヶ月間待ちました。

・・・アレ?

別の理由(ペナルティ?)でインデックス削除されたのかな?

と本気で疑いましたが、特にインデックス削除される程の理由がありません。

というか実験サイトなので静的HTMLページが数ページあるだけです。

CMSも使っていません。

インデックス削除されるまでは、サイト名で検索すると1位で表示されていました。

適当に作ったサイトなので、特に狙っているキーワードなどはありませんでした。

順位計測もしていません。

色々な事を試したら再インデックスされた

以下に3つの方法を記載していますが、待つのが面倒になったので一気に対応してみました。

ですので、実際にどちらが効果的だったのかは分かりません。

両方とも必要だったのかもしれませんし、どちらか片方だけで良かったのかもしれません。

以下の3つの方法を試した所、再インデックスされました。

1.sitemap.xmlを再作成してウェブマスターツールから送信してみました。

2.Fetch as Googlebotを使用して取得したページを[インデックスに送信]してみました。

Fetch as Googlebotの使い方についてはこちらを参考にして下さい。

3.再審査リクエストの送信してみました。

ウェブマスター ツール-再審査をリクエスト

再審査リクエスト時には以下の様な文面を送付しました。(正確な文面は忘れてしまいました。スイマセン)

[サイトURL]のrobotx.txt

[サイトURL]/robots.txt

に関しまして、

——————-

User-agent: *

Disallow: /

——————-

誤って上記の記述をした後にインデックスから削除されてしまいました。○月○日現在、以下の通り修正しております。

——————-

User-agent: *

Sitemap: [サイトURL]/sitemap.xml

Disallow:

——————-恐れ入りますがサイトの再審査をお願い致します。

再審査リクエストから2日後くらいに、Googleから再審査リクエスト受け取りました、という通知がありました。

そして上記3点を対応をした1ヶ月後くらいには、めでたく再インデックスされていました。

ただ、残念ながら実験サイトなので、再インデックス後の順位が変動したのか?という部分までは分かりません。

順位計測をしていない実験サイトだったものですから。。

私と違って順位計測まで含めた実験をされた方がおりましたらコメント欄などで教えて頂けると幸いです。

ちなみにサイト名で検索するとインデックス削除前と変わらず1位でした。

私の予想ですが、再インデックス後に改めて評価されていると思いますので、再インデックス時のアルゴリズムで評価した結果、前よりも評価が上がれば上位に、逆に下がれば下位に順位が変動するのでは無いかと思います。

今回の記事のまとめ

Re:veryさんがnoindexが強力なので使い方に注意しましょう、という記事をアップしているのを見て、以前の実験を思い出し記事にしました。

参考リンク

noindexは強力なので使い方に気をつけよう

SEO業界の方や、サイト制作に携わる方が、凡ミスをするといった事は少ないかも知れませんが、知らずにやってしまって困っているサイト管理者の方も多くいると思いますので記事として残しておきます。

ただ、これが絶対に正しい対処方法とは言えません。

時間がかかっていただけで、対応と同時にタイミング良く再インデックスされただけなのかも知れません。

全ての実験から偶然という要素は拭いきれませんし私は今回1サイトでしか実験していません。

まぁ、こんな事もあるんだ位に考えておいて下さい(笑)

ただ、この実験でも分かる通り、たった1行・1文字の記述ミスだけでインデックスが削除されてしまうほど強力なものもありますので、挙動が分からないものは使わないに越したことはありません。

私の感覚では、robots.txt内のdisallow: /の記述を直せば勝手に再インデックスされると思っていただけに、この実験結果は意外でした。

途中で本当にペナルティを受けたのか、と思いました。。

この4月からWeb業界に飛び込んだ皆さんを脅すつもりはありませんが、ちょっとしたミスや仕様の勘違いが想像以上の被害をもたらしてしまう可能性がある、という事もしっかりと胸に刻んでおいて下さいね(笑)

2012年4月8日追記

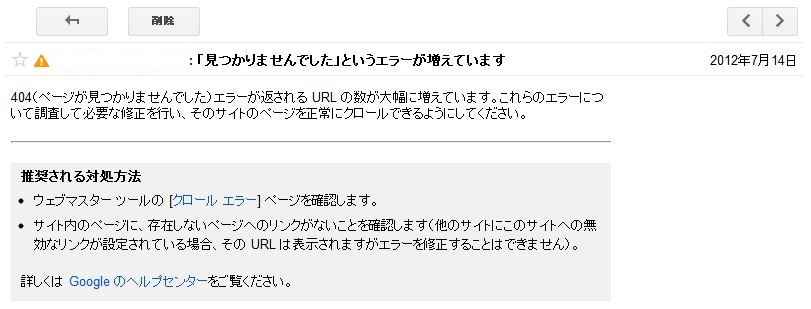

パシフィカス氏がご自身の実験サイトで試した所、ウェブマスターツールへ警告が来る旨をツィートしておりました。

[blackbirdpie url=”https://twitter.com/#!/pacificus/status/188624267523522561″]

僕の実験サイトもウェブマスターツールでその後の状況を見てみたいのですが既に消えてしまったので確認が出来ません。

勿体ない事をしました。。

去年の10月頃の実験だったのですが、私はその実験時にウェブマスターツールを見ていなかったらしく気付きませんでした。

あれだけ高機能なんですからアラートを出して通知してくれそうですもんね。

やはりウェブマスターツールは大切です!

また、返信を頂けまして、

[blackbirdpie url=”https://twitter.com/#!/self0828/status/188642973200814080″]

[blackbirdpie url=”https://twitter.com/#!/pacificus/status/188762512441872386″]

実験開始から2日間ではインデックス削除までは至っていないそうです。

去年、僕が試した時には、2日間でインデックス削除された記憶がありますが、これはタイミングやサイト評価、また当時のGoogleのアルゴリズムなど、色々な要素があるので、一概には言えないのだと思います。

僕自身、この実験に反応して頂いた事で改めて勉強になりました。

※本ブログに記載されている情報は、私の見解に基づく場合が多々ございます。 掲載記事を参考にした事による損害については、その責任を負いかねます。 自己責任で、掲載情報を参考にして頂ければと思います。

これ、結構多いですね。

たむらはん さん

多いんですね。。

実は僕の勘違いもあるのですが、disaalow: /

は直せば勝手に再インデックスされると思っておりました。

どうやら、

ウェブマスターツールから何らかのアクション(Fetch as Googlebotでは無いかと思っています)を起こさなければ再インデックスされない様子です。

事例数が少ないので、他の事例に必ずしも適用されるかは難しい所ですが。。